我们非常兴奋地宣布,在数月的不懈努力之后,EvalsOne正式进入预发布阶段,准备与大家见面了!

我们团队在过去两年一直致力于开发人工智能心理健康聊天机器人。作为OpenAI API技术的早期使用者,我们在产品中集成了提示工程和微调模型,为用户提供独特且有价值的体验。然而,大型语言模型固有的不可预测性,有时会导致用户体验的不一致——这在处理心理健康这么敏感的话题时,可能会带来非常大的麻烦。

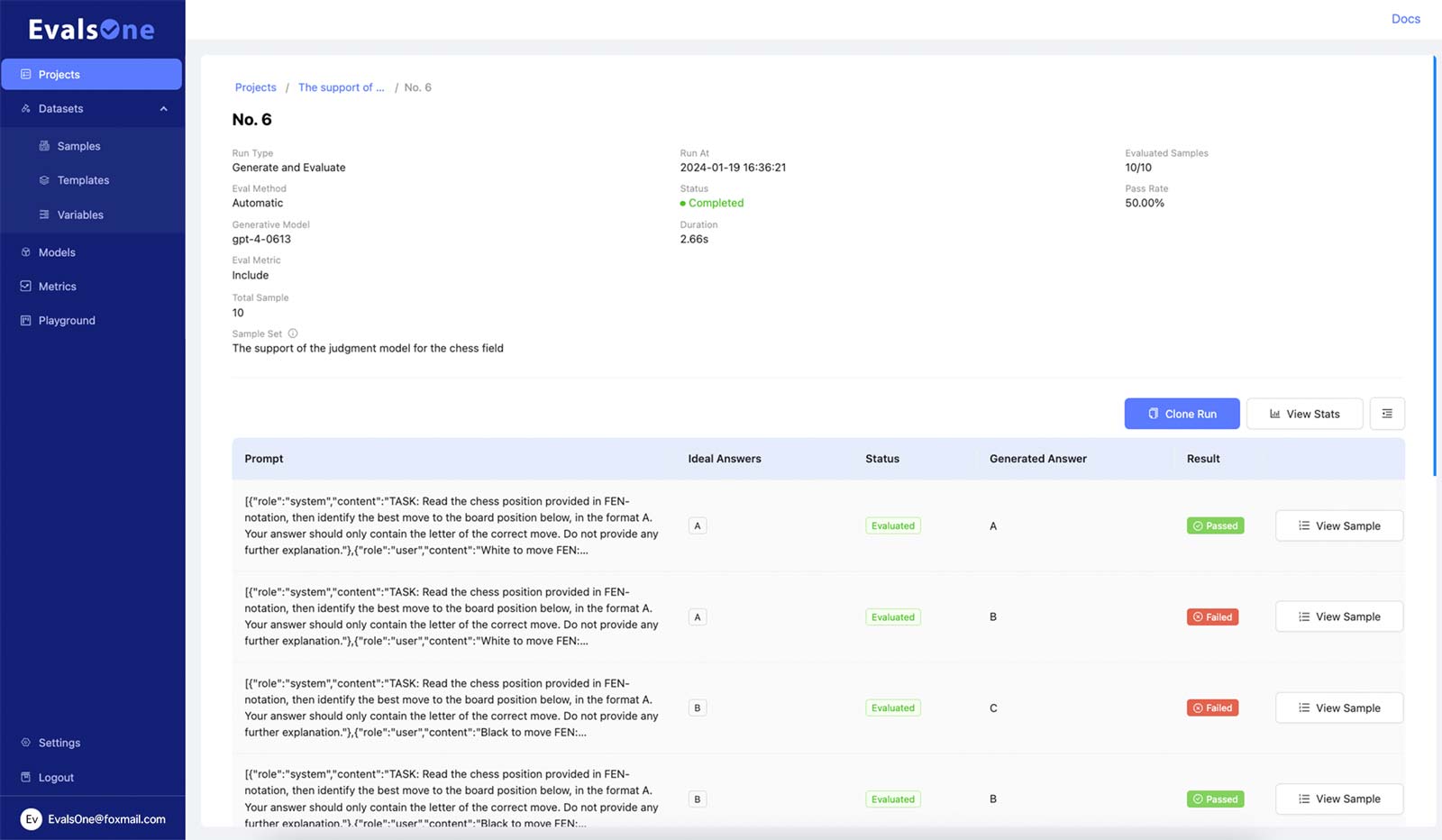

起初,我们依赖于在Playground中进行手动提示语测试,但很快意识到我们需要一种更高效的方法来提高提示语的质量。这促使我们深入探索提示语评估领域。

尽管市场上已有一些提示语评估工具和产品,但它们通常缺乏我们所需的全面性或易用性。决心优化我们的工作流程,我们决定开发自己的解决方案。

我们理想中的产品应该具备:

- 易用性:不应要求高技术门槛,团队中的所有角色都应能轻松使用。

- 开放与灵活性:能够评估各种模型,并灵活设置评估指标。

- 系统性与全面性:应覆盖从样本准备、模型选择、指标设置到结果反馈的整个过程。

基于这一愿景,EvalsOne应运而生。现在,EvalsOne已成为我们内部工作流程不可或缺的一部分,极大地提高了我们的效率,同时显著提升了团队满意度。通过自动化繁琐任务,我们获得了更多专注于创新和创造性工作的自由。

我们现在邀请有限数量的种子用户(初步计划大约200名)加入我们的内测计划,一起塑造LLM提示语评估的未来。作为感谢,您将获得:

- 50美元初始赠送金

- 3个月Standard计划免费使用

现在已经可以在https://evalsone.com 上加入内测的等待名单,率先体验先进的提示语评估平台,并利用它开始构建更好的AI应用,快行动起来吧!